Rund 500 Änderungen geschehen jährlich an den Algorithmen der Google-Suche. Stoff genug um Nutzer und Webmaster monatlich über einige Änderungen zu informieren. In der neuen monatlichen Serie werden vor allem so feine Änderungen genannt, die kaum spürbar sind. Änderungen am Algorithmus sowie am Aussehen des Google-Suchangebotes.

Seit Mitte November hat Google folgende wesentliche Änderungen vorgenommen:

1. Verfeinerung verwandter Suchanfragen

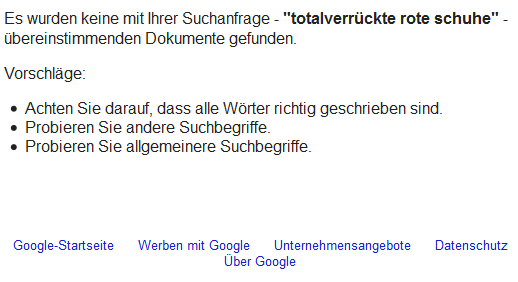

Mitunter werden zu eher seltenen Suchanfragen Treffer gemischt, die auf einer ähnlichen, allgemeineren Suchanfrage beruhen. Sucht man beispielsweise nach

totalverrückte rote schuhe

bedient Google die Anfrage mit zahlreichen Treffern für rote Schuhe. Die Treffer für rote Schuhe übetrumpfen deutlich die Treffer für totalverrückte rote schuhe. Nun sollen die alternativen Antworten nicht mehr so stark die Anworten zur seltenen Suchanfrage übertrumpfen. Im Fachjargon heisst das, dem Longtail wird eine bessere Chance eingeräumt.

Damit wird die kürzliche, interessante Infografik von SEO Book zum verschwindenden Longtail zwar nicht völlig eingeschränkt, aber etwas differenziert.

Für die von mir spontan gewählte Suchanfrage ist es jedoch so, dass Google gar keine Treffer findet. Um sich die Schmach zu ersparen, dem Nutzer zu erklären, dass es keine Treffer gibt, wird also darauf ausgewichen, eine andere, nur bedingt passende Frage zu beanworten.

Nutzt man die Phrasensuche, also Sucbegriff in Anführungszeichen, – “total verrückte rote schuhe” – dann bekommt man tatsächlich die Antwort,

Es wurden keine mit Ihrer Suchanfrage – “totalverrückte rote schuhe” – übereinstimmenden Dokumente gefunden.

Falls Sie liebe Leser, diese Suchanfrage nachvollziehen, wird Google mit hoher Wahrscheinlichkeit bereits eine Webseite liefern: Diesen Blogbeitrag.

2. Umfassendere Indexierung

Diese Änderung macht mehr Longtail Dokumente zugänglich, somit steigt die Wahrscheinlichkeit, dass es eine Anwort zu einer entsprechend speziellen Suchanfrage gibt.

3. Neue Klassifizierung geparkter Domains

Geparkte Domains enthalten selten nützliche Inhalte. Geparkte Domains haben fast immer keine wertvollen Inhalte für Nutzer. In den meisten Fällen wird Google die Domains nicht zeigen.

Google hat selbst mit einem speziellen Programm AdSense für Domains dafür gesorgt, dass die Besitzer legal über Google-Anzeigen Geld verdienen. Was heisst, auch Google verdient damit. Diesen Interessenkonflikt will Google nun offenbar doch im Sinne besserer Suchergebnisse lösen.

4. Mehr Vorhersagen für die automatische Vervollständigung

Google sucht hier nach einer Balance zwischen flexiblen Vorschlägen und der tatsächlichen Absicht der Nutzer. Der Algorithmus wurde flexibler gestaltet.

Wie sich das auswirkt muss sich zeigen. Theoretisch könnte das eine weitere Massnahme sein um den Vorwurf zu entkräften, der Longtail würde keine Chance haben.

5. Umfassendere und aktuellere Blogresultate

Der spezielle Index der Blogsuche von Google soll aktueller und umfassender werden.

Frischer und umfassender geht natürlich immer. Bisher wurden Blogpost jedoch bereits wirklich gut erfasst. Normalerweise sind Blogposts innerhalb weniger Minuten im Index. Nicht nur im Blogindex auch in der Websuche.

6. Erkennung des Originals bei mehrfach gleichen Inhalten

Es wurde die Erkennung verbessert, welcher Inhalt bei zwei identischen Webseiten das Original ist.

7. Aktualität der Bildersuche

Die Änderung betrifft die Suche nach Nachrichten-Bildern. Durch eine Änderung zurr Bestimmung der Aktualität der Bilder sollen nun häufiger die aktuellsten Bilder angezeigt werden.

Siehe dazu auch tagSeoBlog: In 2 Stunden in die Universal-Search (Bilder-Onebox)

8. Umschreibung von Code für TOP-Treffer

Eine zusätzliche Behandlung der TOP-Treffer in der Ergebnisliste. Beispielsweise wird sichergestellt, dass nicht zu viele Treffer von einer Website angezeigt werden.

Google war bisher bereits bemüht, nicht mehr als zwei Treffer von einer Domain zu zeigen. Andererseits blendet Google Sitelinks im Großformat ein, was bedeutet, der Platz der ersten 6 Treffer wird von einer Domain mit Sitelinks belegt. Diese großformatigen Sitelinks kommen allerdings nur bei ausgewählten Suchanfragen zur Anwendung.

9. Layout-Änderungen für Tablet-PC

Kleine Änderungen an Farbe und Layout für eine bessere Darstellung auf Tablet-PC’s.

10. Live Resultate für Major League Soccer und Kanadische Fussball-Liga

Die aktuellsten Spielstände und Spielpaarungen werden angezeigt, einschliesslich Zugriff auf Spielezusammenfassungen und Punktestand.

Vielleicht bringt Google diese Aktualität zukünftig für den deutschen Fussball?

Google Inside Search Blog:

Search quality highlights: new monthly series on algorithm changes

Comments

4 responses to “10 Algorithmische Änderungen der Google Suche – Dezember 2011”

Danke für diese Zusammenstellung.

Gibt es Infos dazu, WIE Google erkennt, welcher Text ein Original und keine Kopie ist?

Herzlich, Nicola Straub

Hallo Nicola,

Es ist bekannt dass Google einen sogenannten Hash-Tag erzeugt. Könnte man als einzigartigen Fingerabdruck einer Webseite bezeichnen. Die Summe aller Zeichen auf einer Seite ergibt bereits dann einen anderen Hash-Tag wenn nur ein Zeichen verändert wurde. So starr ist Google jedoch nicht immer, damit auch Texte erkannt werden die nur weitgehend identisch sind.

Google prüft welche Seite zuerst von der Suchmaschine entdeckt wurde. Bei Blogs ist das ziemlich einfach, weil die einen Ping senden und somit nahezu zeitgleich mit der Veröffentlichung das Signal senden, dass etwas veröffentlicht wurde. Schwieriger ist das für Seiten die kein Signal senden und nur gelegentlich von Google besucht werden. Wer immer die Möglichkeit hat, mit seinem CMS, Blog oder Shopsoftware einen Ping zu senden sollte das unbedingt tun. Ähnliche Ergebnisse erreicht man, wenn mit der Veröffentlichung zeitgleich in soziale Netzwerke gepostet wird. Insbesondere Twitter, denn dort gibt es auch einen Zeitstempel.

Am PageRank orientiert sich Google ebenfalls. In der Regel wird einer Seite mit höherem PageRank das Original zugeschrieben. Obwohl das häufig passend ist und gut funktioniert, passieren natürlich auch Fehleinschätzungen.

Merkt Google, dass auf einer Webseite häufig oder generell Kopien von Texten auftauchen, dann wird Google solch einer Website kein Vertrauen schenken.

Zusammenfassend kann man sagen, dass Google mehrere Signale heranzieht um das Original zu erkennen. Perfekt ist Googles Verfahren zur Originalerkennung nicht.

Interesaante Liste, besonders die Doubletten Erkennung und die weiter gefasst Indexierung war mir neu, danke für den artikel.

[…] wo Fachportale bessere und interessantere Inhalte bieten. Zum anderen lässt es aktuell mit dem letzten großen Update des Algorithmus gerne mal einen Suchbegriff weg oder interpretiert relativ frei, was der Sucher […]